L'AI Act

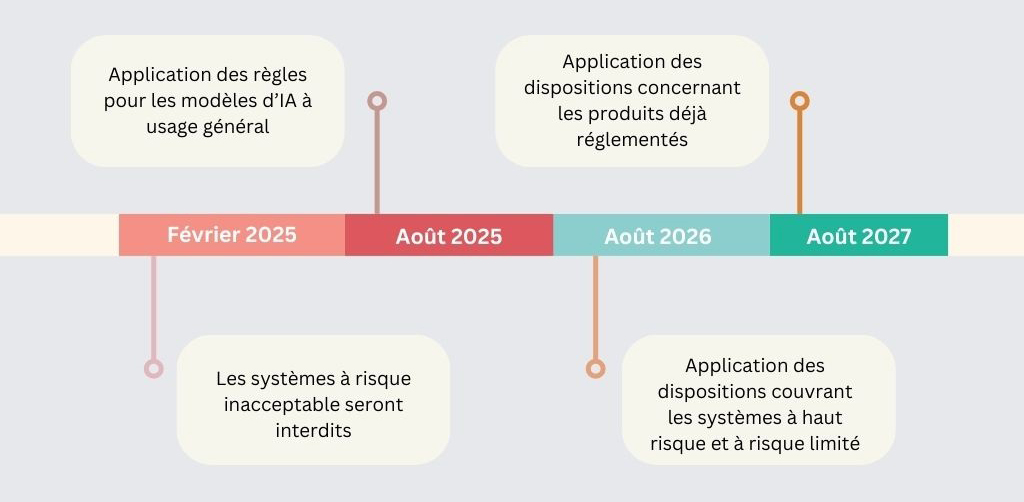

Le règlement 2024/1689 de l’Union européenne sur l’intelligence artificielle, dit AI Act, est entré en vigueur le 2 août 2024, ce qui a fait démarrer son calendrier progressif d’entrée en application.

Calendrier d'application

Définition des nouveaux acteurs

Ce règlement a pour objectif d’établir des règles harmonisées sur l’intelligence artificielle au sein de l’Union européenne sans freiner l’innovation. Il crée de nouvelles obligations pour une pluralité d’acteurs.

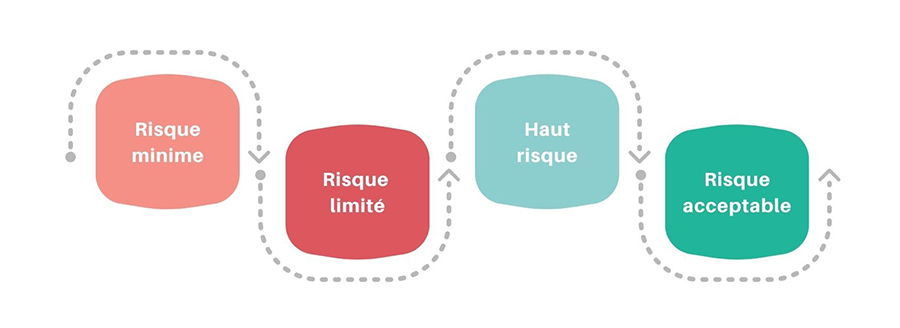

En effet, les systèmes d’intelligence artificielle sont réglementés en fonction de leur niveau de risque :

Le législateur européen cherche à mettre en place un cadre juridique adapté. Les obligations imposées varient selon le niveau de risque, avec des exigences spécifiques pour les systèmes à haut risque. Ces systèmes doivent respecter des critères rigoureux, notamment en matière de données, de robustesse technique et de surveillance humaine.

Ainsi l’IA Act identifie les opérateurs suivants :

- Fournisseur : il utilise sous sa propre autorité un SIA à titre professionnel développé sous son propre nom ou marque.

- Déployeur : il utilise sous sa propre autorité un SIA à titre professionnel mais ne l’a pas développé sous son propre nom ou marque.

- Mandataire : désigné par mandat écrit du fournisseur, le mandataire s’acquittera en son nom des obligations et procédures.

- Importateur : il met sur le marché un SIA qui porte le nom ou la marque d’un fournisseur établi dans un pays tiers.

- distributeur : cet opérateur fait partie de la chaîne d’approvisionnement, autre que le fournisseur ou l’importateur, et met un SIA à disposition sur le marché de l’Union.

Des obligations spécifiques pour chacun des acteurs

Le Règlement européen prévoit des exigences et obligations pour chaque opérateur de la chaîne de valeur afin de garantir la conformité, la sécurité et la transparence des systèmes d’IA.

Le texte impose au fournisseur de système d'IA à haut risque de se conformer aux exigences suivantes :

- Système de gestion des risques

- Données et gouvernance des données

- Documentation technique précise

- Enregistrement automatique des journaux

- Transparence et fourniture d’information

- Contrôle humain

- Exactitude, robustesse et cybersécurité

Le fournisseur, en tant que concepteur de système d’IA, est soumis à des obligations supplémentaires conformément à l’article 16 de l’AI Act, dont la mise en œuvre d’un système de gestion de la qualité.

Le déployeur a également des obligations spécifiques :

- Selon l’article 26, il doit s’assurer que le contrôle humain est confié à des personnes compétentes et formées, et que le système est utilisé conformément à sa notice d’utilisation.

- Il doit également veiller à la qualité et à la représentativité des données d’entrée, surveiller le fonctionnement du système et maintenir une communication active avec le fournisseur. L’information du patient est également à la charge du professionnel de santé et de l’établissement de santé, en contact direct avec celui-ci.

En cas de non-respect de ces obligations, le Règlement européen sur l’intelligence artificielle prévoit, selon son article 99, une amende administrative pouvant aller jusqu’à 15 000 000 euros ou 3 % du chiffre d’affaires annuel mondial total réalisé au cours de l’exercice précédent. À préciser que ce montant est différent selon le niveau de risque.

Toujours selon le même article, le non-respect des pratiques interdites (à risque inacceptable) en matière d’IA fait l’objet d’amendes administratives pouvant aller jusqu’à 35 000 000 euros ou 7 % de son chiffre d’affaires annuel mondial total, le montant le plus élevé étant retenu.

Les fournisseurs et déployeurs de systèmes d'IA, indépendamment de leur niveau de risque, doivent également :

- assurer pour leur personnel un niveau suffisant de maîtrise de l'IA, à savoir les compétences, les connaissances et la compréhension qui permettent aux fournisseurs, aux déployeurs et aux personnes concernées, compte tenu de leurs droits et obligations respectifs dans le contexte du présent règlement, de procéder à un déploiement des systèmes d’IA en toute connaissance de cause ;

- prendre conscience des possibilités et des risques que comporte l’IA, ainsi que des préjudices potentiels qu’elle peut causer.

Ce nouveau cadre de compliance est complété par l’actualisation des régimes de responsabilité existants, en particulier la Directive (UE) 2024/2853 relative à la responsabilité du fait des produits défectueux.

Directive (UE) 2024/2853 relative à la responsabilité du fait des produits défectueux

La directive européenne (UE) 2024/2853 relative à la responsabilité du fait des produits défectueux marque une évolution dans le cadre réglementaire européen, notamment en réponse aux avancées technologiques et à l'intégration de l'intelligence artificielle.

Entrée en application le 8 décembre 2024, sa transposition en droit interne par les États membres devra être opérée avant le 9 décembre 2026

Un champ d'application vaste

L'une des principales continuités avec le texte de 1985 réside dans ses objectifs fondamentaux :

Cependant, la directive élargit désormais la définition des produits pour inclure les logiciels et certains services numériques connectés dit "service connexe". Ces services connexes, des services numériques intégrés ou interconnectés, doivent être compris comme étant des composants du produit.

Cette intégration reflète l'importance croissante des technologies numériques dans la conception et l'utilisation des produits.

—

Elle prend également en compte des aspects spécifiques à l'intelligence artificielle, comme la capacité des produits à évoluer ou à interagir avec d'autres systèmes, ainsi que les exigences de cybersécurité.

Sur les responsabilités

Sur le plan de la responsabilité, le texte introduit des mécanismes visant à équilibrer l'asymétrie d'information entre les fabricants et les victimes concernées.

En effet, il est prévu que les défendeurs devront apporter des preuves en cas de litige. La défectuosité du produit ainsi que le lien de causalité entre ce défaut et le dommage pourront être présumés.

Cependant, ces présomptions restent simples et peuvent être réfutées par le défendeur en apportant une preuve contraire par tout moyen. Ces dispositions sont particulièrement adaptées aux systèmes d’IA complexes, où les preuves techniques sont souvent difficiles d’accès pour les victimes.

Les dommages pris en charge sont également élargis. La directive inclut désormais des atteintes à la santé psychologique et des dommages liés à la corruption ou à la destruction de données non professionnelles.

Des défis majeurs restent encore à relever

Bien qu’ils constituent une avancée significative, ces textes soulèvent des interrogations quant à leur interaction avec d’autres cadres réglementaires existants.

Une attention particulière devra être portée à leur intégration pour garantir une cohérence d’ensemble, prévenir les chevauchements juridiques et éviter une complexité qui pourrait en limiter l’applicabilité.

Ces textes seront donc confrontés à des défis majeurs, notamment leur capacité à suivre les évolutions constantes et rapides des innovations technologiques. Leur mise en œuvre sera déterminante pour évaluer leur adaptabilité et leur pertinence face au nouvel environnement mis en place par l’IA.

En parallèle, l’intelligence artificielle continue de transformer profondément les pratiques médicales, apportant des solutions innovantes tout en soulevant des enjeux éthiques et juridiques.